إنتروبي مشترك

الإنتروبي المشترك (بالإنجليزية: joint entropy)، يعتبر في نظرية المعلومات مقياسًا لعدم اليقين المرتبط بمجموعة من المتغيرات.[1]

| نظرية المعلومات |

|---|

|

|

|

|

تعريف

إنتروبي شانون المشتركة (بوحدة البتات) من متغيرين عشوائيين منفصلين و مع الصور و يعرف بأنه [3] :16

|

حيث و هي قيم خاصة و ، على التوالي، هو الاحتمال المشترك لحدوث هذه القيم معًا، و يعرف بأنه 0 إذا .

لأكثر من متغيرين عشوائيين هذا يتوسع إلى

|

حيث هي قيم خاصة ، على التوالي ، هو احتمال حدوث هذه القيم معًا، و يعرف بأنه 0 إذا .

الخصائص

عدم السلبية

الإنتروبيا المشتركة لمجموعة من المتغيرات العشوائية هي عدد غير سالب.

أكبر من الانتروبيا الفردية

الإنتروبيا المشتركة لمجموعة من المتغيرات أكبر من أو تساوي الحد الأقصى لجميع الأنتروبيا الفردية للمتغيرات في المجموعة.

أقل من أو يساوي مجموع الانتروبيا الفردية

الإنتروبيا المشتركة لمجموعة من المتغيرات أقل من أو تساوي مجموع الأنتروبيا الفردية للمتغيرات في المجموعة. هذا مثال على الجمع الثانوي. هذا اللامساواة تعتبر مساواة إذا وفقط اذا كان و مستقلين إحصائيا. [3] :30

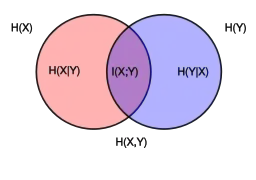

العلاقات مع قياسات الإنتروبي الأخرى

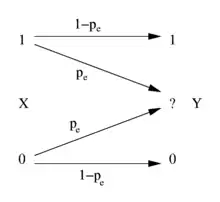

يستخدم الانتروبي المشترك في تعريف الإنتروبي الشرطي [3] :22

- ،

و

كما أنها تستخدم في تعريف المعلومات المتبادلة [3] :21

في نظرية المعلومات الكمومية، يتم تعميم الإنتروبيا المشتركة في الإنتروبيا الكمومية المشتركة.

الانتروبيا التفاضلية المشتركة

التعريف أعلاه هو للمتغيرات العشوائية المنفصلة ولم يعد صالحًا في حالة المتغيرات العشوائية المستمرة. تسمى النسخة المستمرة من إنتروبيا المفصل المنفصل إنتروبيا المفاصل (أو المستمر) . لتكن و متغيرات عشوائية مستمرة ذات دالة كثافة احتمالية مشتركة . الانتروبيا المشتركة التفاضلية يعرف بأنه [3] :249

لأكثر من متغيرين عشوائيين متواصلين يعمم التعريف على:

يتم أخذ جزء لا يتجزأ من دعم . من الممكن ألا يكون التكامل موجودًا وفي هذه الحالة نقول أن الإنتروبي التفاضلي غير محدد.

كما في الحالة المنفصلة، يكون الانتروبيا التفاضلية المشتركة لمجموعة من المتغيرات العشوائية أصغر أو تساوي من مجموع الأنتروبيا للمتغيرات العشوائية الفردية:

- [3] :253

تنطبق قاعدة السلسلة التالية على متغيرين عشوائيين:

في حالة وجود أكثر من متغيرين عشوائيين يتم تعميم هذا على: [3] :253

يستخدم الإنتروبي التفاضلي المشترك أيضًا في تعريف المعلومات المتبادلة بين المتغيرات العشوائية المستمرة:

المراجع

- Theresa M. Korn; Korn, Granino Arthur. Mathematical Handbook for Scientists and Engineers: Definitions, Theorems, and Formulas for Reference and Review. New York: Dover Publications. ISBN 0-486-41147-8. الوسيط

|CitationClass=تم تجاهله (مساعدة) - D.J.C. Mackay. Information theory, inferences, and learning algorithms. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Thomas M. Cover; Joy A. Thomas. Elements of Information Theory. Hoboken, New Jersey: Wiley. ISBN 0-471-24195-4. الوسيط

|CitationClass=تم تجاهله (مساعدة)

- بوابة رياضيات

- بوابة علم الحاسوب

- بوابة الفيزياء