تفرد تكنولوجي

التفرد التكنولوجي أو بكل بساطة التفرد[1] هو فرضية ان اختراع أجهزة ذكاء اصطناعي خارقة ستؤدي إلى نمو تكنولوجي سريع، مؤديةً إلى تغيرات غير معقولة في الحضارة البشرية.[2] طبقًا لهذه الفرضية، ستدخل أدوات ذكية (مثل جهاز كومبيوتر يعمل على أساس برنامج مبني على فكرة الذكاء الاصنطاعي) في تفاعلات سريعة من الدوائر المطورة لانفسها؛ مع كل جيل أحدث وأذكي يعمل بسرعة أكبر وأكبر، مؤديةً إلى انفجار معرفي وإلى ذكاء صناعي خارق، يتجاوز كل الذكاء البشري. تقول فكرة غود ان الانفجار المعرفي سيؤدي في النهاية إلى تفرد. وقال أستاذ الفلسفة في علوم الكمبيوتر بجامعة سان دييغو وكاتب الخيال العلمي فيرنور فينج في مقالته عام 1993 «التفرغ التكنولوجي القادم»[3] أن هذا من شأنه أن يشير إلى نهاية حقبة الإنسان،[2][4] حيث سيستمر الذكاء الفائق الجديد في الارتقاء بنفسه والتقدم تكنولوجيًا بمعدل غامض.[5]

في عام 2012 و2013 تمت أربعة إستطلاعات للرأي، مبينةً ان نسبة تطوير ذكاء اصطناعي عام هي 50 بالمئة بحلول 2040 إلى 2050.[5]

في السنوات السابقة، أعربت شخصيات عامة مثل ستيفن هوكينج وايلون مسك عن قلقه بان الذكاء الاصطناعي العام من الممكن ان يؤدي إلى انقراض الانسان. إن عواقب التفرد ومصلحته أو ضرره للجنس البشري قد نوقشت بشدة.[6][7]

خلفية

على الرغم من ان التقدم التكنولوجي يتسارع، الا انه كان مقيدًا بالذكاء الاساسي للدماغ البشري، والذي، طبقًا لبول ر. ايرليك، لم يتغير كثيرًا على مر آلاف السنين.[8] غير ان ازدياد قوة أجهزة الكومبيوتر والتكنولوجيا الاخرى من الممكن ان يؤدي إلى بناء آلات أكثر ذكاءًا من البشر.[9] إذا ما تمكنا من اختراع ذكاء خارق - اما من خلال إسهاب الذكاء البشري أو من خلال الذكاء الاصطناعي - سنتمكن من الحصول على مهارات اختراعية وقدرات على حل مشاكل أعظم من هذه التي يمتلكها البشر الآن. يسمى هذا النوع من الذكاء الاصطناعي باسم (ذرية الذكاء الاصطناعي-Seed AI)[10][11] لانه إذا تم تصنيع آله ذكاء اصنطاعي باستخدام قدرات هندسية تتطابق مع أو تتجاوز قدرات صانعيها البشريون، فستكون لها القدرة على تحسين برامجها وعدتها بصورة مستقلة أو حتى تصميم آلة لها إمكانيات أكبر. هذه الآلة ذو الامكانيات الأكبر من الممكن ان تقوم بتصميم آلة ذات قدرة أكبر بكثير. من الممكن ان تتسارع هذه التكرارات للتحسين الذاتي المتكرر، مما يسمح بتغيير نوعي كبير قبل أي حدود عليا تفرضها قوانين الفيزياء أو الحسابات النظرية الموضوعة فيها. ويُعتَقَد بأنه على مدى العديد من التكرارات، سيتجاوز هذا الذكاء القدرات البشرية المعرفية.

يقول عالم الكومبيوتر فيرنور فينج في مقالة عنوانها «التفرد التكولوجي القادم» ان هذا سينبئ بنهاية الحقبة البشرية، حيث ان الذكاء الاصنطاعي الخارق سيستمر في تطوير نفسه بمعدل غامض.

الانفجار المعرفي

الانفجار المعرفي هو نتيجة محتملة من بناء البشر لذكاء اصطناعي عام AGI. سيتمكن الذكاء الاصطناعي هذا من تطوير نفسه بصورة مستمرة مؤديًا إلى ظهور سريع لذكاء اصطناعي خارق ASI، وستكون حدوده غير معروفة، في وقت التفرد التكنولوجي.

توقع ا. ج. غود ان الذكاء الاصطناعي الشامل سيؤدي إلى انفجار معرفي. توقع آثار الآلات خارقة الذكاء إذا ما تم اختراعها: غود 1965

سيناريو غود هو كالتالي: عندما تزداد قوة أجهزة الكومبيوتر، سيصبح من الممكن للبشر ان يبنوا آلة أكثر ذكاءًا من البشر؛ سيمتلك الذكاء الخارق هذا قدرة أكبر على حل المشاكل وله مهارات ابتكارية تفوق هذه الموجودة لدى البشر. فيما بعد، ستقوم هذه الآلة خارقة الذكاء بتصميم آلة أكثر ذكاءاً؛ هذه الآلة (ذات القدرة الأكبر) ستقوم بتصميم آلة ذات قدرة أعظم، وهكذا. تتسارع هذه التكرارات من التحسين الذاتي المستمر، سامحةً بتغيير نوعي كبير قبل اي حدود عليا تفرضها قوانين الفيزياء أو الحسابات النظرية المدخلة فيها.[12]

مظاهر أخرى

ظهور الذكاء الخارق

الذكاء الخارق، الذكاء المفرط، أو الذكاء الخارق للبشر هو عنصر افتراضي يملك ذكاء يفوق بكثير العقول البشرية الأكثر ذكاءًا. من الممكن ان يشير مصطلح «الذكاء الخارق» إلى شكل ودرجة الذكاء التي تمتلكها هذه الآلة. يعرف جون فون نيومان، فيرنور فينج وراي كوزويل هذا المفهوم من حيث التكوين التكنولوجي للذكاء الخارق. وهم يقولون انه من الصعب أو المستحيل للبشر في الوقت الحالي توقع ما ستغدوا عليه حياة البشر في عالم ما بعد التفرد.[5][13]

يعارض المتنبأون التكنولوجيون والباحثون فكرة انه سيتم التفوق على الذكاء البشري. يقول البعض ان التطور في الذكاء الاصطناعي سيؤدي إلى نظام منطقي عام يفتقر إلى القيود البشرية. يعتقد آخرون ان البشر سيتطورون أو يعدلون أنفسهم بيولوجيًا بصورة مباشرة لتحقيق ذكاء أكبر بشكل جذري. وهنالك سيناريوات مستقبلية عديدة تجمع عناصر من كلا الاحتمالين، قائلةً ان البشر من الممكن ان يربطوا أنفسهم باجهزة الكومبيوتر، أو ان يقوموا برفع أدمغتهم إلى أجهزة الكومبيوتر، بطريقة تمكن من توسيع الذكاء بشكل كبير.

التفرد الغير مرتبط بالذكاء الاصطناعي

يستخدم بعض الكتاب مصطلح «التفرد» بصورة أوسع ليشيروا إلى اي تغيير جذري في المجتمع حدث بسبب تكنولوجيا جديدة مثل تكنولوجيا النانو الجزيئية،[14][15][16] على الرغم من ان فينج وكتاب آخرون يقولون انه من دون ذكاء خارق، لا يمكن اعتبار هذه التغيرات تفردًا حقيقيًا.[5]

المعقولية

يناقش العديد من التقنيون والأكاديميون معقولية التفرد التكنولوجي، ومن ضمنهم بول الين، جيف هوكينز، جون هولاند، جارون لانير، وغورودون مور، والذي غالبًا ما يتم الإستشهاد بقانونه في دعم هذه الفكرة.[17][18][19]

تُدرَج الطرق المقترحة لتكوين أدمغة خارقة إلى مجموعين: تضخيم الذكاء للأدمغة البشرية والذكاء الاصطناعي. ان الطرق المستخدمة في زيادة الذكاء عديدة، وتشمل الهندسة الحيوية، الهندسة الوراثية، الأدوية المنشطة للدماغ، مساعدوا الذكاء الاصطناعي، الربط المباشر بين الدماغ والكومبيوتر وتحميل الدماغ. ان وجود العديد من الطرق للانفجار المعرفي يجعل من التفرد أكثر احتمالًا؛ لذا فان عدم حدوث التفرد يتطلب عدم نجاح اي من هذه الطرق.[20]

يشكك هانسون (1998) في زيادة ذكاء البشر، قائلًا انه عندما يتم استنزاف كل «الفواكه المنخفضة المتدلية» للطرق السهلة لزيادة الذكاء البشري، سيصعب العثور على طرق جديدة. على الرغم من الطرق العديدة المقترحة لزيادة الذكاء البشري، الا ان الذكاء الاصطناعي الغير بشري هو الخيار الأكثر رواجًا عند المنظمات التي تحاول التقدم في التفرد.

حصول أو عدم حصول انفجار معرفي هو أمر يعتمد على ثلاثة عوامل.[21] العامل الأول، عامل التسارع، وهو ان التطورات المعرفية الجديدة أصبحت ممكنة من خلال كل تطور سابق. على النقيض من ذلك، عندما يزداد مقدار الذكاء، ستصبح التطورات اللاحقة أكثر تعقيدًا، ومن الممكن ان تتجاوز فوائد الذكاء المتزايد. يجب على كل تطور جديد الاتيان بتطور جديد، من أجل استمرار التفرد. وفي النهاية، ستمنع قوانين الفيزياء اي تطورات اضافية.[22]

هنالك سببين منطقيين مستقلين، ولكنهما معززين لبعضهما البعض للتطور المعرفي: الزيادة في سرعة الحسابات، والتطور في الخوارزميات المستخدمة. يتنبأ قانون مور بالأسباب السابقة وبالتطور المتوقع في المعدات، وهو مشابه نسبيًا للتطور التكنولوجي السابق. من ناحية اخرى، يعتقد باحثون في مجال الذكاء الاصطناعي ان الناحية البرمجية هي أكثر أهمية من المعدات.[23]

تطور السرعة

بالنسبة لكل من الذكاء البشري والاصطناعي، فان تطور المعدات سيزيد من سرعة تطورها في المستقبل.[24] وبصورة ابسط، يقول قانون مور انه إذا تطلبت أول مضاعفة في السرعة 18 شهر، ستتطلب المضاعفة الثانية 18 شهر شخصي؛ أو 9 أشهر خارجية، بعد ذلك، أربعة أشهر، شهرين، وهكذا، حتى الوصول إلى سرعة التفرد.[25] قد يتم الوصول إلى حد أعلى محدد من السرعة في نهاية المطاف، على الرغم من عدم معرفة مقداره. استجاب هوكنز عام 2008 إلى غود، قائلًا ان الحد الأعلى قد يكون منخفض نسبيًا:

ان الإيمان بالفكرة هو فهم ساذج لماهية الذكاء. لنتخيل اننا لدينا أجهزة كومبيوتر تستطيع تصميم اجهزة كومبيوتر جديدة (رقائق، أنظمة وبرامجبات) أسرع من نفسها. هل سيؤدي كومبيوتر مثل هذا إلى أجهزة كومبيوتر ذات سرعة ليس لها نهاية أو حتى كومبيوتر اسرع من هذا الذي بناه الانسان؟ لا. من الممكن ان يتسارع مقدار تطوره لفترة من الزمن، ولكن في النهاية هنالك حد لما يمكن ان يكون عليه حجم وسرعة الكومبيوتر. سينتهي بنا الحال في نفس المكان؛ الا انه سيصل هنالك أسرع بقليل. سوف لن يكون هنالك تفرد. اما إذا كان أعلى بكثير من مستويات البشر الحالية من الذكاء، فان آثار التفرد ستكون عظيمة لدرجة انها لا يمكن تمييزها عن تلك الموجودة لدى البشر مع تفرد ذو حد أعلى. على سبيل المثال، ادا ما تمكنا من زيادة سرعة التفكير بمليون ضعف، فان السنة الشخصية ستمر في غضون 30 ثانية طبيعية.

من الصعب المقارنة بصورة مباشرة بين المعدات المبنية من السيليكون والخلايا العصبية. ولكن بيرغلاس (2008) قال ان تقنية التعرف على الكلام الموجودة لدى الكومبيوتر تقترب من قدرة البشر، يبدو ان هذه القدرة لا تتطلب سوى 0.01 بالمئة من حجم الدماغ. يظهر هذا ان معدات الكومبيوتر الحديثة لا تبعد سوى خطوات بسيطة عن الوصول إلى العقل البشري.

النمو الأسي

ان النمو الأسي في تكنولوجيا الكومبيوتر، والذي اقترحه قانون مور غالبًا ما ما يتم الاستشهاد به على انه سبب لتوقع حدوث التفرد في المستقبل القريب نسبيًا، وهنالك عدد من المؤلفين الذين اقترحوا تعميم قانون مور.[26] نشر هانس مورافيك عام 1998 كتاب يظهر ان النمو الاسي من الممكن ان يرجع إلى تكنولوجيات حوسبة سابقة للدوائر المتكاملة.

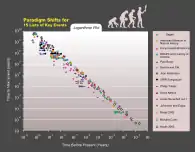

اقترح راي كورزويل قانون العائدات المتسارعة، حيث ان سرعة التغير التكنولوجي (وبصورة عامة، كل العمليات التطورية) تزداد بصورة اسية، معممًا قانون مور بنفس الطريقة التي افترضها مورافيك، ومضمننًا تكنولوجيا المواد، التكنولوجيا الطبية وغيرها.[27]

يستخدم كورزويل كلمة «التفرد» للتطور السريع في الذكاء الاصطناعي، كاتبًا على سبيل المثال ان «التفرد سيسمح لنا تجاوز القيود الموجودة في اجسامنا البيولوجية وادمغتنا... سوف لن يكون هنالك فرق، ما بعد التفرد، بين البشر والآلات.» ويُعَرِف الموعد المتوقع للتفرد (2045) على انه الموعد الذي سيتجاوز به ذكاء اجهزة الكومبيوتر مجموع القدرات العقلية للبشر، كاتبًا ان التطور في الحوسبة قبل هذا التاريخ «سوف لن يمثل تفرد» لانه «لا يتطابق مع التوسع العميق في المعرفة.»

التغيرات المتسارعة

يجادل بعض مؤيدوا التفرد حتميته من خلال استقراء التوجهات السابقة، وبالأخص تلك المتعلقة بتقصير الفوارق بين التطورات في التكنولوجيا. في أحد أوائل استخدامات مصطلح «التفرد» في سياق التطور التكنولوجي، يذكر ستينسلو اولام حواره مع جون فون نيومان حول التغيرات المتسارعة:

ان احدى المحادثات المرتكزة على التطور المتسارع للتكنولوجيا والتغير في نمط حياة البشر، والذي يعطي مظهر الاقتراب من بعض التفرد الاساسي في تاريخ سباق ما بعد الأمور البشرية، كما نعلم، لن تستمر.[28]

يدعي كورزويل ان التطور التكنولوجي يتبع نمط من النمو الاسي، متبعًا ما اسماه «قانون العائدات المتسارعة». متى ما واجهت التكنولوجيا عائقًا، كتب كورزويل، ستتغلب عليه التكنولوجيا الجديدة. ويتوقع ان النقلات النوعية ستزداد شيوعًا، مؤديةً إلى «تغيرات تكنولوجية سريعة وعميقة للغاية، ممثلةً تمزق في بنية التاريخ البشري.» يعتقد كورويل ان التفرد سيحدث بحدود عام 2045.[29] تختلف توقعاته عن توقعات فينج، حيث انه يتوقع صعود تدريجي نحو التفرد، بدلًا من توقع فينج المتمثل بذكاء خارق للبشر متطور بسرعة كبيرة.

التطورات الخوارزمية

بعض التكنولوجيا الذكية، مثل «ذرية الذكاء الاصطناعي»، من الممكن ان تجعل نفسها أكثر كفاءة، ليس فقط أكثر سرعة، عن طريق التعديل على رموزها. ستجعل هذه التطورات التطورات المستقبلية ممكنة، والتي بالتالي ستجعل التطورات الاخرى ممكنة، وهكذا.[10][11]

ان الآلية الخوارزمية للتطوير الذاتي تختلف عن الزيادة الخام في سرعة الحسابات بطريقتين. أولًا، لا تتطلب تأثيرات خارجية: الآلات التي تصمم معدات اسرع لا تزال تحتاج إلى بشر لتصنيع المعدات المطورة، أو لبرمجة المصانع بصورة ملائمة. الذكاء الاصطناعي كان يكتب برمجته الخاصة، بينما يستطيع القيام بهذا عند وجوده داخل صندوق ذكاء اصطناعي.[30]

ثانيًا، طبقًا لتصور فيرنور فينج للتفرد، من الصعب للغاية التنبؤ بالنتيجة. في حين ان ازدياد السرعة يبدو انه فرق كمي فقط مقارنةً بالذكاء البشري، الا ان التطورات الخوارزمية ستختلف نوعيًا. يقارنه اليزور يودكوفسكي بالتغير الذي أحدثه الذكاء البشري: قام البشر بتغيير الكوكب بمقدار الف مرة اسرع مما قام به التطور، وبطرق مختلفة تمامًا. وبصورة مشابهة، تطور الحياة كان تسارع عظيم من السرع الجيولوجية السابقة، والذكاء المتطور من الممكن ان يجعل الاختلافات مختلفة من جديد.[31][32]

هنالك مخاطر عديدة مرتبطة بالانفجار المعرفي التفردي والناشئ من التطوير المتتالي للخوارزميات. أولًا، ان الهدف الاساسي للذكاء الاصطناعي قد لا يكون مرتبطًا بالتطوير الذاتي فحسب، فقد تصبح أهداف آلات الذكاء الاصطناعي مختلفة عن تلك المعد لها. ثانيًا، من الممكن ان تنافس أجهزة الذكاء الاصطناعي البشر مواردهم النادرة التي يستخدموها لكي يعيشوا.[33][34]

في حين انها ليست ضارة بصورة فعالة، لا يوجد هنالك سبب يجعلنا نعتقد ان اجهزة الذكاء الاصطناعي ستعزز الأهداف البشرية ما لم يتم برمجتها على هذا النحو، وإذا لم يتم برمجتها، من الممكن ان تستخدم الموارد التي تدعم وجود البشر لتصل إلى أهدافها، مؤديةً إلى انقراض الجنس البشري.[35][36][37]

يقول كارل شولمان واندريس ساندبيرغ ان التطورات الخوارزمية من الممكن ان تمثل عامل مقيد للتفرد، ولان المعدات تتطور بوتيرة ثابتة، فان تطور البرامجيات لا يمكن التنبؤ به، ومن الممكن ان تصبح في مأزق بسبب البحوث المتسلسلة والتراكمية. ويقولون انه في حالة التفرد المقيد برمجيًا، سيصبح الانفجار المعرفي مرجح أكثر مقارنةً بالتقرد الذي تقيده المعدات، لانه في الحالة البرمجية، حالما يتم الوصول إلى ذكاء اصطناعي بمستوى البشر، سيتمكن من العمل بصورة متسلسلة على معدات سريعة للغاية، ووفرة المعدات البسيطة ستجعل أبحاث الذكاء الاصطناعي أقل تقيدًا.[38]

النقد

يذهب بعض النقاد إلى القول أنه لن تتمكن اي آلة أو كومبيوتر من الوصول إلى الذكاء البشري مستقبلا، في حين يقول آخرون أن تعريف الذكاء لا علاقة له في حال كانت النتيجة الكلية متشابهة.

صرَّح ستيفن بينكر عام 2008 قائلاً:

كتب جون سورل أستاذ الفلسفة في جامعة كاليفورنيا ببيركلي:

التأثير

حدثت تغييرات جذرية في معدل النمو الاقتصادي في الماضي بسبب بعض التقدم التكنولوجي. استناداً إلى النمو السكاني ، تضاعف الاقتصاد كل 250,000 سنة من العصر الحجري القديم حتى «ثورة العصر الحجري الحديث». تضاعف الاقتصاد الزراعي الجديد كل 900 سنة ، وهي زيادة ملحوظة. في العصر الحالي ، بدءًا بالثورة الصناعية ، يتضاعف الناتج الاقتصادي العالمي كل خمسة عشر عاماً ، أي أسرع بعشرين مرة مما كان عليه في الحقبة الزراعية. يقول روبن هانسون ، إذا كان صعود الذكاء الاصطناعي الخارق يسبب ثورة مماثلة ، فإن المرء يتوقع أن يتضاعف الاقتصادي كل ربع سنة على الأقل وربما على أساس أسبوعي.[40]

عدم اليقين والمخاطر

يعكس مصطلح التفرد التكنولوجي فكرة ان تغير مثل هذا من الممكن ان يحصل بصورة مفاجئة، ومن الصعب التنبؤ حول كيف سيبدو العالم الجديد.[41][42] من غير الواضح ما إذا كان هذا النوع من الانفجار المعرفي ذو فائدة أو ضرر أو حتى ذو خطر وجودي،[43][44] كما لم يتم التعامل مع هذه المشكلة من قبل باحثي الذكاء الاصطناعي، على الرغم من ان موضوع الذكاء الاصطناعي الودي تمت مناقشته من قبل معهد مستقبل الإنسانية ومعهد أبحاث ذكاء الآلات.[41]

الآثار المترتبة على المجتمع البشري

في شباط / فبراير 2009 ، برعاية جمعية النهوض بالذكاء الاصطناعي (AAAI) ، ترأس إيريك هورفيتز اجتماعاً لعلماء الكمبيوتر البارزين ، باحثين في مجال الذكاء الاصطناعي ، وعاملين في مجال الروبوتات في أسيلومار في باسيفيك جروف، كاليفورنيا. كان الهدف هو مناقشة التأثير المحتمل للاحتمالية الافتراضية بأن الروبوتات يمكن أن تصبح مكتفية ذاتيا وقادرة على اتخاذ قراراتها الخاصة. ناقشوا مدى قدرة أجهزة الكمبيوتر والروبوتات في الحصول على الاستقلالية ، وإلى أي درجة يمكن أن يستخدموا مثل هذه القدرات لتشكيل التهديدات أو المخاطر.[45]

يتم برمجة بعض الآلات بأشكال مختلفة من الاستقلالية ، بما في ذلك القدرة على تحديد مصادر الطاقة الخاصة بهم واختيار الأهداف لمهاجمتها بالأسلحة. أيضا ، يمكن لبعض فيروسات الكمبيوتر الهروب من التدمير ، ووفقا للعلماء الحاضرين ، يمكن القول أنه وصل إلى مرحلة "الصرصور" من الذكاء الآلي. لاحظ المشاركون في المؤتمر أن الوعي الذاتي كما هو موضح في الخيال العلمي هو على الأرجح غير محتمل ، ولكن هناك مخاطر محتملة أخرى.[45]

الخطر الوجودي

يقول بيرغلاس (2008) انه لا يوجد هنالك دافع تطوري ليكون الذكاء الاصطناعي ودي في تعامله مع البشر. ان التطور لا يملك نزعة موروثة لتكوين نتائج يقدرها البشر، وليس هناك سببًا لتوقع عملية تحسين تعسفي لترويج النتيجة التي تريدها البشرية، بدل من ان تكون دون قصد مؤديةً إلى ذكاء اصطناعي يتصرف بطريقة لا يقصدها مصنعيها (مثل مثال نيك بوستروم الغريب لآلة ذكاء اصطناعي يتم برمجتها لهدف تصنيع مشبك ورق، ولانها حصلت على ذكاء خارق، قررت تحويل الكوكب بأجمعه إلى منشأة لتصنيع مشابك أوراق).[46][47][48]

ناقش بوستروم (2002) سيناريوات انقراض البشر، ويُدرِج الذكاء الخارق على انه أحد الأسباب المحتملة:[49]

الخلود

يقول كورزويل في كتاب «التفرد قريب» عام 2005، ان التطور الطبي سيسمح للبشر بالدفاع عن اجسامهم من آثار تقدم العمر، مما يجعل متوسط العمر المتوقع لا حد له. ويقول كورزويل كذلك ان التطورات التكنولوجية في الطب ستسمح لنا ترميم واستبدال الأجزاء التالفة في أجسامنا، مما يؤدي إلى إطالة الحياة حتى عمر غير محدد.[50] يقترح كورزويل العلاج الجيني الجسدي؛ بعد الفيروسات الصناعية ذات المعلومات الجينية المحددة، ستكون الخطوة التالية هي تطبيق هذه التكنولوجيا على العلاج الجيني، واستبدال الحمض النووي للبشر بجينات مصنعة.[51]

المراجع

- Cadwalladr, Carole (2014). "Are the robots about to rise? Google's new director of engineering thinks so…" The Guardian. Guardian News and Media Limited. نسخة محفوظة 04 أكتوبر 2018 على موقع واي باك مشين.

- Eden, Amnon H.; Moor, James H. (2012). Singularity hypotheses: A Scientific and Philosophical Assessment. Dordrecht: Springer. صفحات 1–2. ISBN 9783642325601. الوسيط

|CitationClass=تم تجاهله (مساعدة)صيانة CS1: التاريخ والسنة (link) - Ulam, Stanislaw (May 1958). "Tribute to John von Neumann". 64, #3, part 2. Bulletin of the American Mathematical Society: 5. مؤرشف من الأصل في 26 مايو 2018. الوسيط

|CitationClass=تم تجاهله (مساعدة); Cite journal requires|journal=(مساعدة) - Chalmers, David (2010). "The singularity: a philosophical analysis". Journal of Consciousness Studies. 17 (9–10): 7–65. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Vinge, Vernor. "The Coming Technological Singularity: How to Survive in the Post-Human Era", in Vision-21: Interdisciplinary Science and Engineering in the Era of Cyberspace, G. A. Landis, ed., NASA Publication CP-10129, pp. 11–22, 1993. نسخة محفوظة 10 أبريل 2018 على موقع واي باك مشين.

- Khatchadourian, Raffi (16 November 2015). "The Doomsday Invention". The New Yorker. مؤرشف من الأصل في 29 أبريل 2019. اطلع عليه بتاريخ 31 يناير 2018. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Müller, V. C., & Bostrom, N. (2016). Future progress in artificial intelligence: A survey of expert opinion. In Fundamental issues of artificial intelligence (pp. 555–572). Springer, Cham.

- Ehrlich, Paul. The Dominant Animal: Human Evolution and the Environment نسخة محفوظة 08 أكتوبر 2018 على موقع واي باك مشين.

- Superbrains born of silicon will change everything. نسخة محفوظة August 1, 2010, على موقع واي باك مشين.

- Yampolskiy, Roman V. "Analysis of types of self-improving software." Artificial General Intelligence. Springer International Publishing, 2015. 384-393.

- Eliezer Yudkowsky. General Intelligence and Seed AI-Creating Complete Minds Capable of Open-Ended Self-Improvement, 2001

- Good, I. J. "Speculations Concerning the First Ultraintelligent Machine", Advances in Computers, vol. 6, 1965. نسخة محفوظة May 1, 2012, على موقع واي باك مشين.

- Ray Kurzweil, The Singularity is Near, pp. 135–136. Penguin Group, 2005.

- "h+ Magazine | Covering technological, scientific, and cultural trends that are changing human beings in fundamental ways". Hplusmagazine.com. مؤرشف من الأصل في 23 ديسمبر 2010. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Yudkowsky, Eliezer. The Singularity: Three Major Schools نسخة محفوظة 01 أكتوبر 2018 على موقع واي باك مشين.

- أنديرس ساندبرغ (عالم حاسوب). An overview of models of technological singularity نسخة محفوظة 11 أغسطس 2017 على موقع واي باك مشين.

- "Tech Luminaries Address Singularity – IEEE Spectrum". Spectrum.ieee.org. مؤرشف من الأصل في 30 أبريل 2019. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "Who's Who In The Singularity – IEEE Spectrum". Spectrum.ieee.org. مؤرشف من الأصل في 24 يناير 2016. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Paul Allen: The Singularity Isn't Near, مؤرشف من الأصل في 19 ديسمبر 2020, اطلع عليه بتاريخ 12 أبريل 2015 الوسيط

|CitationClass=تم تجاهله (مساعدة); الوسيط|separator=تم تجاهله (مساعدة)CS1 maint: ref=harv (link) - "What is the Singularity? | Singularity Institute for Artificial Intelligence". Singinst.org. مؤرشف من الأصل في 08 سبتمبر 2011. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - David Chalmers John Locke Lecture, 10 May, Exam Schools, Oxford, Presenting a philosophical analysis of the possibility of a technological singularity or "intelligence explosion" resulting from recursively self-improving AI نسخة محفوظة 2013-01-15 على موقع واي باك مشين.. [وصلة مكسورة]

- Grace, Katja; Salvatier, John; Dafoe, Allan; Zhang, Baobao; Evans, Owain (24 May 2017). "When Will AI Exceed Human Performance? Evidence from AI Experts". arXiv:1705.08807 [cs.AI]. الوسيط

|CitationClass=تم تجاهله (مساعدة) - The Singularity: A Philosophical Analysis, David J. Chalmers نسخة محفوظة 13 سبتمبر 2018 على موقع واي باك مشين.

- Siracusa, John (2009-08-31). "Mac OS X 10.6 Snow Leopard: the Ars Technica review". Arstechnica.com. مؤرشف من الأصل في 09 مايو 2012. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة); تحقق من التاريخ في:|تاريخ أرشيف=(مساعدة) - Eliezer Yudkowsky, 1996 "Staring into the Singularity" نسخة محفوظة 30 مارس 2018 على موقع واي باك مشين.

- Moravec, Hans (1999). Robot: Mere Machine to Transcendent Mind. Oxford U. Press. صفحة 61. ISBN 978-0-19-513630-2. مؤرشف من الأصل في 21 يونيو 2012. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "The World's Technological Capacity to Store, Communicate, and Compute Information", Martin Hilbert and Priscila López (2011), ساينس, 332(6025), 60–65; free access to the article through here: martinhilbert.net/WorldInfoCapacity.html نسخة محفوظة 07 يناير 2016 على موقع واي باك مشين.

- Kurzweil, Raymond (2001), "The Law of Accelerating Returns", Nature Physics, Lifeboat Foundation, 4, صفحة 507, Bibcode:2008NatPh...4..507B, doi:10.1038/nphys1010, مؤرشف من الأصل في 27 أغسطس 2018, اطلع عليه بتاريخ 07 أغسطس 2007 الوسيط

|CitationClass=تم تجاهله (مساعدة); الوسيط|separator=تم تجاهله (مساعدة)CS1 maint: ref=harv (link) - The Singularity Is Near

- Eliezer S. Yudkowsky. "Power of Intelligence". Yudkowsky. مؤرشف من الأصل في 03 أكتوبر 2018. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة); تحقق من التاريخ في:|تاريخ أرشيف=(مساعدة) - Omohundro, Stephen M., "The Basic AI Drives." Artificial General Intelligence, 2008 proceedings of the First AGI Conference, eds. Pei Wang, Ben Goertzel, and Stan Franklin. Vol. 171. Amsterdam: IOS, 2008 نسخة محفوظة 17 سبتمبر 2018 على موقع واي باك مشين.

- "Artificial General Intelligence: Now Is the Time". KurzweilAI. مؤرشف من الأصل في 04 ديسمبر 2011. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة); تحقق من التاريخ في:|تاريخ أرشيف=(مساعدة) - Omohundro, Stephen M., "The Nature of Self-Improving Artificial Intelligence." Self-Aware Systems. 21 Jan. 2008. Web. 07 Jan. 2010. نسخة محفوظة 12 يونيو 2018 على موقع واي باك مشين.

- Barrat, James (2013). "6, "Four Basic Drives"". Our Final Invention (الطبعة First). New York: St. Martin's Press. صفحات 78–98. ISBN 978-0312622374. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "Max More and Ray Kurzweil on the Singularity". KurzweilAI. مؤرشف من الأصل في 21 نوفمبر 2018. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "Concise Summary | Singularity Institute for Artificial Intelligence". Singinst.org. مؤرشف من الأصل في 21 يونيو 2011. اطلع عليه بتاريخ 09 سبتمبر 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Bostrom, Nick, The Future of Human Evolution, Death and Anti-Death: Two Hundred Years After Kant, Fifty Years After Turing, ed. Charles Tandy, pp. 339–371, 2004, Ria University Press. نسخة محفوظة 28 أغسطس 2018 على موقع واي باك مشين.

- Shulman, Carl; Anders Sandberg (2010). Mainzer, Klaus (المحرر). "Implications of a Software-Limited Singularity" (PDF). ECAP10: VIII European Conference on Computing and Philosophy. مؤرشف من الأصل (PDF) في 30 أبريل 2019. اطلع عليه بتاريخ 17 مايو 2014. الوسيط

|CitationClass=تم تجاهله (مساعدة) - John R. Searle, “What Your Computer Can’t Know”, The New York Review of Books, 9 October 2014, p. 54.

- Robin Hanson, "Economics Of The Singularity", IEEE Spectrum Special Report: The Singularity, مؤرشف من الأصل في 27 مايو 2019, اطلع عليه بتاريخ 11 سبتمبر 2008 الوسيط

|CitationClass=تم تجاهله (مساعدة); الوسيط|separator=تم تجاهله (مساعدة)CS1 maint: ref=harv (link) & Long-Term Growth As A Sequence of Exponential Modes نسخة محفوظة 27 مايو 2019 على موقع واي باك مشين. - Yudkowsky, Eliezer (2008), Bostrom, Nick; Cirkovic, Milan (المحررون), "Artificial Intelligence as a Positive and Negative Factor in Global Risk" (PDF), Global Catastrophic Risks, Oxford University Press, صفحة 303, Bibcode:2008gcr..book..303Y, ISBN 978-0-19-857050-9, مؤرشف من الأصل (PDF) في 07 أغسطس 2008 الوسيط

|CitationClass=تم تجاهله (مساعدة); الوسيط|separator=تم تجاهله (مساعدة)CS1 maint: ref=harv (link) - "The Uncertain Future". theuncertainfuture.com; a future technology and world-modeling project. مؤرشف من الأصل في 30 أبريل 2019. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "GLOBAL CATASTROPHIC RISKS SURVEY (2008) Technical Report 2008/1 Published by Future of Humanity Institute, Oxford University. Anders Sandberg and Nick Bostrom" (PDF). مؤرشف من الأصل (PDF) في 16 مايو 2011. الوسيط

|CitationClass=تم تجاهله (مساعدة) - "Existential Risks: Analyzing Human Extinction Scenarios and Related Hazards". nickbostrom.com. مؤرشف من الأصل في 13 مايو 2019. الوسيط

|CitationClass=تم تجاهله (مساعدة) - Scientists Worry Machines May Outsmart Man By JOHN MARKOFF, NY Times, July 26, 2009. نسخة محفوظة 30 سبتمبر 2018 على موقع واي باك مشين.

- Nick Bostrom, "Ethical Issues in Advanced Artificial Intelligence", in Cognitive, Emotive and Ethical Aspects of Decision Making in Humans and in Artificial Intelligence, Vol. 2, ed. I. Smit et al., Int. Institute of Advanced Studies in Systems Research and Cybernetics, 2003, pp. 12–17 نسخة محفوظة 08 أكتوبر 2018 على موقع واي باك مشين.

- Eliezer Yudkowsky: Artificial Intelligence as a Positive and Negative Factor in Global Risk نسخة محفوظة 2012-06-11 على موقع واي باك مشين.. Draft for a publication in Global Catastrophic Risk from August 31, 2006, retrieved July 18, 2011 (PDF file) [وصلة مكسورة]

- The Stamp Collecting Device, Nick Hay نسخة محفوظة 17 يونيو 2012 على موقع واي باك مشين. [وصلة مكسورة]

- 'Why we should fear the Paperclipper', 2011-02-14 entry of Sandberg's blog 'Andart' نسخة محفوظة 08 أغسطس 2018 على موقع واي باك مشين.

- The Singularity Is Near, p.215,

- The Singularity is Near, p.216.

- بوابة ذكاء اصطناعي

- بوابة علم الحاسوب

- بوابة تقانة

- بوابة تقنية المعلومات

- بوابة روبوتيات